*本文為劍橋大學法學專家Christopher Markou觀點,不代表本站立場。

看過科幻電影《鷹眼》的人可能有印象,當電腦能機械式地認定一個人有罪,不論你扶過多少奶奶過馬路,平常做過多少善事,只要一經它標記你這輩子就GG了,完全幾乎沒有人性的斟酌考慮。

依此印象來看,無法綜合斟酌考量,大概就是機器AI無法取代法官的主要原因。但近期美國首席法官約翰羅伯特(John Roberts)提到的事可能令人擔憂,「現在法院已經開始慢慢引進人工智慧了,這對司法的執行與限縮公權力有很大的幫助。」羅伯特這麼說著。

羅伯特所指的案例,大概就是影射近期威斯康辛州的艾瑞克‧路米斯(Eric Loomis)案,由於有私人研發的AI軟體協助與介入,使得被告路米斯被判六年以上監禁。路米斯在過去曾有犯罪經歷,軟體報告寫出他是「偷車逃避警察追緝」,最後他因畏罪潛逃而被判刑,這讓他不斷向外界宣稱自己的權利被「不正當的法律程序」侵犯了,因為他自己與委任律師都無法得知是否該軟體有其判斷正當性。

犯罪報告是從一種叫Compas的軟體匯出的,製造這軟體的Nortpointe公司將其販售上市並銷售給美國法院。這是來自一個用新科技幫助改善司法效率的大型計畫,目的是讓法官在審理期間有著更多資訊可以使用。

雖然路米斯的犯罪報告還未公布,但據我們對於軟體的了解,這份報告的內中可能包含了大量圖表、數據以量化路米斯的生活、行為以及在犯罪的可能性,此外還包括他的年齡、種族、性別認同、上網習慣以及像是尻槍頻率等等你不想知道的數據,重點是我們不知那些除了年齡以外的數字是怎麼被算出來的。

「就數據層面來講,他有較高的暴力傾向,較高的再犯可能與較高的事先審理風險」提其公訴的檢察官如此對法官說著。雖然這在法庭攻防審判中是常聽到的官方化,但法官卻被這種說法說服了,並告訴路米斯,他被Compas軟體鑑定為危害社會的高度危險個體。

最後威斯康辛州最高法院判定路米斯有罪,並補充說Compas報告對此判決有著重大貢獻,但又加上了一個但書,「即使沒有這份報告Loomis也會受到相同的判決。」這句註解引起了軒然大波,我們怎麼能認定軟體沒有影響我們的判決呢?

當然威斯康辛州最高法院這樣做無不法之處,只是用這種方法審判給人民觀感不好。這讓人不禁去思考一件事,我們根本不知道AI或者其他電腦演算法會如何影響審判。

劍橋大學法學專家克里斯托弗·馬庫(Christopher Markou)就為此提到,目前市面上有很多AI公司想要分食司法審查這塊大餅,而Compas系統就是一種像是司法界的「試用研究計畫」,因為跟對方有簽訂商業機密的合作,所以法院方完全無法公佈在審理過程中何時使用它,以及如何使用該系統的細節。

而馬庫也提到,實際上整個法律審理過程當中,最先使用AI的過程並不是審理過程,而是調查過程。英國警方近年來已引進一個叫做VALCRI的系統來協助辦案,將在接下來三年裡使用它處理650萬則匿名數據;在比利時安特衛普的警方也在進行類似的AI調查工作。但馬庫也警告說,依過去的經驗以研究,用這種深度學習AI處理犯罪數據,會產生許多難以避免的問題。

當然科技的趨勢必定是要逐漸減輕法庭繁重的程序,從影印機到DNA指紋識別和超複雜的監視系統,都一再地為法庭提供關鍵證據,但這並不意味只要有技術都是一種進步。在調查和審判中使用AI雖然能節省時間金錢,這也會引起很多棘手的問題。

非營利組織ProPublica就曾提出了一份Compas報告,該報告指出在佛羅里達州的案例,軟體會認為黑人比白人更容易有再犯風險;近期英國巴斯大學資工教授貝森(Joanna Bryson)也透過研究表示,即使是最複雜的AI,也會繼承設計者的種族和性別偏見。

那為什麼司法要把決策的一部分工作,分配給由某個人設計的出來的軟體?

馬庫提到,法律標準從來就不是完美無缺的,而是我們作為人所允許的最大能力。我們可以犯錯,但隨著時間推移和經驗累積,我們會知道如何不再犯錯,不斷精煉這個系統,這就是我們的司法。

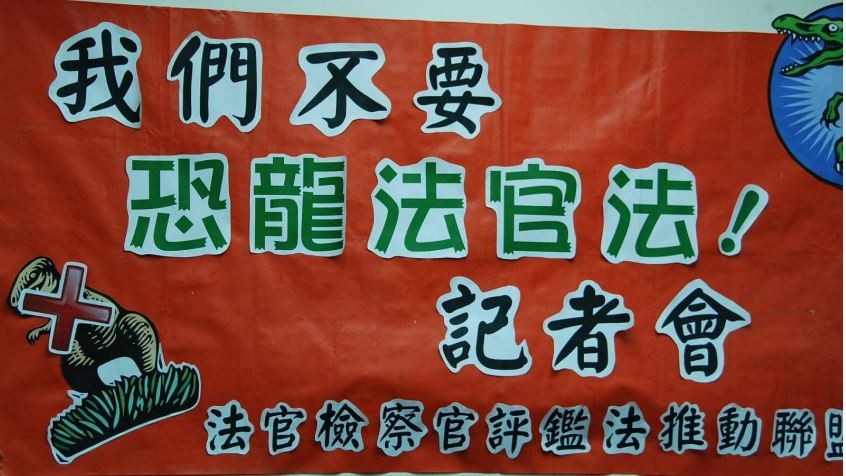

但他堅稱,任何類似像Compas的AI系統就是讓法律系統走向黑箱作業,必須堅決反對。法律體系的訊息必須由連續性,透明性以及回顧性。如果AI審判真是不可避免的趨勢,那麼開發出開源、可檢查可評論的Compas軟體是一種改進方法,司法不應該放棄公正性而選擇去保護這種開發者的利益。

最後馬庫提到了司法自身的問題,在將責任推卸給電腦軟體之前,我們必須保證司法系統的本身的可信度夠高,而不是把AI當作司法不用改革的藉口。

▼▼▼▼快來幫胖丁按個讚▼▼▼▼