▲Google Pixel 相機開發的產品經理 Isaac Reynolds。(圖/記者洪聖壹攝)

記者洪聖壹/台北報導

今年獲得 DXOmark 最高分的 Google Pixel 2 持續以單鏡頭設計獨霸群雄,《ETtoday新聞雲》在稍早 Google 所舉辦的當中,訪問到了負責 Google Pixel 相機開發的產品經理 Isaac Reynolds,能夠做到最大差異化的,最主要是導入 AI 人工智慧,同時也說明了之所以不隨波逐流採用雙鏡頭的原因。

現在所有高階手機,都提供一樣的效能、相似的設計,其實已經越來越沒有意義,要從中做出差異化、符合人們需求,主要還是要透過建立在機器學習基礎之上的人工智慧(以下簡稱AI),透過 AI 協助機器更快速、正確的做出反應。

以 Google Pixel 內建的 Google Lens 為例,用戶不管用前鏡頭還是主鏡頭,只要對著歷史建築物拍照,就可以知道建築物名稱,如果對著書本拍照,就可以知道書本名稱、作者、售價、購買地點等相關訊息,如果對著博物館拍照,不僅可以知道博物館名稱,還可以知道博物館歷史背景跟館藏,還有現在正在做什麼展覽活動等等,這都是透過 AI 的協助,連動原有的Google搜尋、Google翻譯、Google地圖等服務,快速做出的自動化反應。

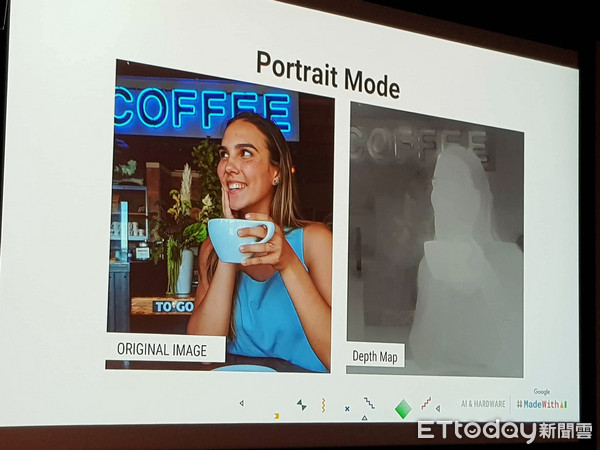

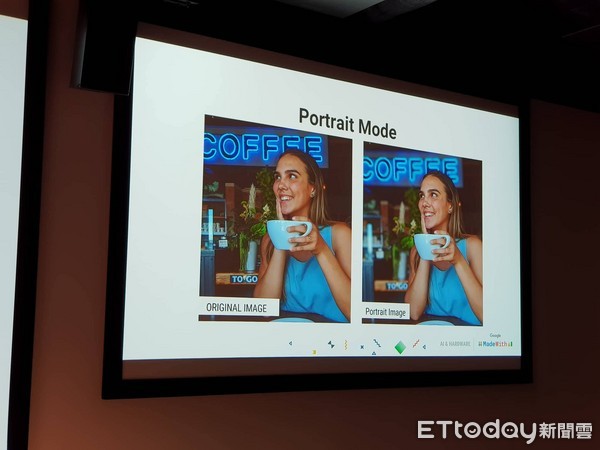

而 Google Pixel 也是如此,像是 Google Pixel 2 的人像模式過 AI 可以認識拍出來的影像當中,哪些是人像、哪些是物理環境,藉此快速模擬深度地圖,有效區別出人像與背景,兩者互相結合起來,做出超越 DSLR 相機的人像景深拍攝效果。

Google Pixel 相機開發的產品經理 Isaac Reynolds 解釋,Pixel 手機的人像模式主要是透過機器學習的技術,然後提升人物本體的銳利度,並根據手機跟人物的距離,自動辨識畫面當中的人物與拍攝場景當中的遠近距離,建構出深度圖譜,藉此決定背景模糊的程度,製造出景深的效果。

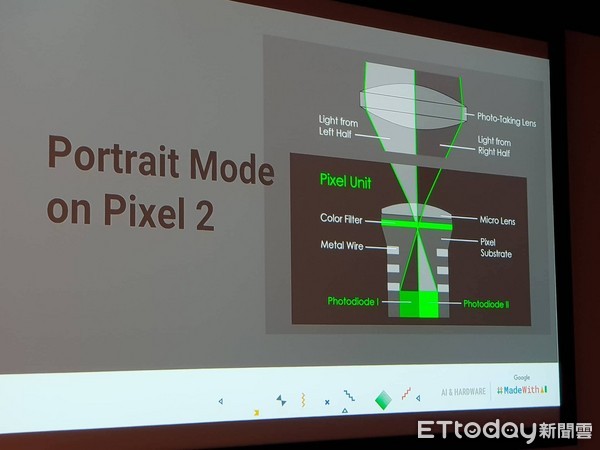

到了 Pixel 2 的相機使用了一組特殊的影像感應器,相當於人類的雙眼,透過將左、右兩邊的視域呈像所呈現的微小差別,來預測出景點中距離。

其原理是,透過將上述的感應器偵測到的每個正方形像素,分割成兩個較小的矩形子像素,一個在左邊、另一個在右邊。用戶拍照時,Google 使用所有的左邊的子像素拍攝一張照片,所有的右邊的子像素拍攝另一張照片,藉此產出上述的深度圖。

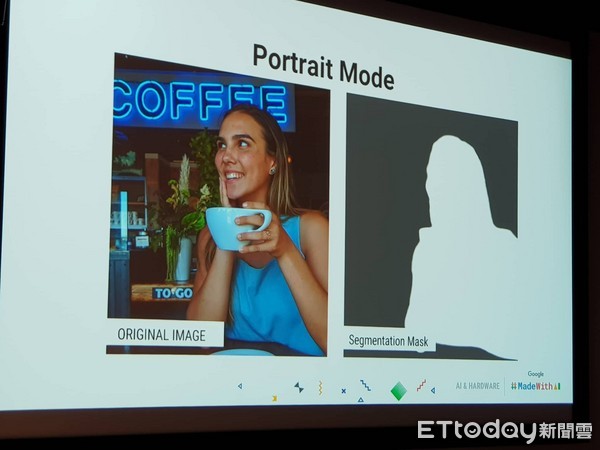

接著Pixel 2會使用機器學習技術來計算「劃分遮罩」(segmentation mask),這項機器學習技術的背後已經學習了近百萬張人物、服飾以及背景圖像,因此這個劃分遮罩中的像素變得銳利,遮罩外的像素變得模糊。接著 Google 將這個「劃分遮罩」和「深度圖」組合成一張優化過的深度圖,然後根據估計的距離決定背景模糊的程度。

記者進一步詢問,在上述處理的過程中,是否有跟晶片廠合作?以及究竟相片好看比較重要、還是接近真實比較重要?Isaac Reynolds 受訪時回應,他會希望相片更接近真實場景會比較重要,而 Google 確實在開發手機的時候跟合作夥伴有緊密結合,當然 CPU 能耗處理、GPU 與 ISP 管理等也有跟晶片廠深度合作。

至於針對現有廠商多半都採用雙鏡頭的解決方案,尤其是自從 2016 年 iPhone 7 Plus 推出之後,市場上幾乎都採用廣角+長焦的雙彩色鏡頭解決方案。

對此,Isaac Reynolds 回應,如過透過雙鏡頭是為了拍出更好看的景深效果,那麼 Pixel 透過人工智慧已經可以做得很好,而且在影像細節上還能達到最佳效果,對比之下,雙鏡頭雖然可以很方便做出一些拍攝效果,但是對於手機來說,拍攝時所需消耗的資源太多,這包括需要更多暫存記憶體、更多電力等等。

但他也不把話說死,直說:「要達到好的照片效果有很多好的方法,我們會持續做出不一樣的事情,只是我們現在選擇單鏡頭,未來不排除任何可能性。」

讀者迴響