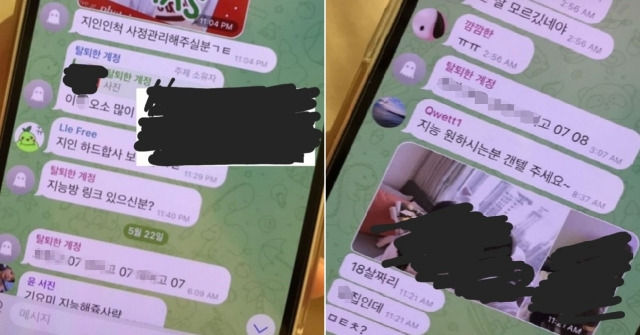

▲Telegram上出現以製作深偽技術合成性剝削影片為目的的對話群組。(圖/翻攝自X)

記者羅翊宬/編譯

全球人工智慧技術(AI)發達以後,人體圖像合成「深偽技術」(Deepfakes)犯罪手法層出不窮,以現有圖像合成性剝削影片,並透過社群平台Telegram和其他網站散播,3年來受害者不僅逐年倍增,且高達6成是未成年人。如今,警方已經逮捕拘提2名涉案嫌犯,並移送檢方處置。

根據《韓聯社》,針對近來深偽技術犯罪氾濫,首爾警察廳成立集中對應專案小組,本月22日將在Telegram成立聊天群組「友人凌辱房」、製作並散播合成性剝削影像的20多歲男性嫌犯A某逮捕拘提到案,並於今(30)日將其移送檢方。

A某從今年5月至7月在Telegram開設聊天群組「友人凌辱房」,並從其他參加會員獲取女性友人們的臉部照片、年齡等個人資訊,合成製作279個性剝削影片,並廣為散播,受害者多達246人。

至於另一名30多歲男性嫌犯B某4年來則是負責經營成人網站,從2020年12月起開始經營,為的就是獲取賭博網站的廣告收益,直到被逮前總共製作並散播2萬多部以兒童、青少年為對象的性剝削影像。

B某為了躲避司法機關的追緝和放送通信審議委員會的封鎖,竟然購買了85個網域名稱,以便隨時做更換,並經營成人網站,同時負責經營另外5個網站以負責宣傳。

南韓共同民主黨籍國會議員楊富男從警察廳獲取相關統計資料,發現2021至2023年每一年深偽技術受害者的人數是逐年遞增,且光是未成年受害者就占6成,2021年受害者為53人、2022年為81人、2023年為181人,在總計527名受害者中,未成年人的比例為59.8%(315人)。

★★★五、性影像事件警語範例:

(一) 保護被害人隱私,避免二度傷害。

(二) 移除下架性影像,洽性影像處理中心。

(三) 終結性影像,不拍攝、不持有、不下載、不分享。

讀者迴響